انتاب امرأة القلق بعدما سمعت صوت ابنتها تبكي في مكالمة هاتفية يزعم رجل فيها أنه خطف الفتاة ويطالب بفدية... إلا أنّ نبرة صوت المراهقة لم تكن حقيقية بل مُبتكرة بواسطة تقنية الذكاء الاصطناعي، وهي مسألة مُقلقة تبرز مع هذه التكنولوجيا التي تشهد ازدهاراً في المرحلة الراهنة.

يشير الخبراء إلى أنّ الخطر الأبرز للذكاء الاصطناعي يتمثّل في قدرة هذه التقنية على تبديدها تقريباً الخط الفاصل بين الحقيقة والخيال، وتزويد المجرمين بأدوات فعّالة وغير مكلفة.

تثير عمليات احتيال هاتفية حديثة باستخدام أدوات النسخ الصوتي المُستندة إلى الذكاء الاصطناعي والمتاحة بسهولة عبر الإنترنت، قلق السلطات الأميركية.

تسمع جينيفر ديستيفانو، وهي أم تقيم في ولاية أريزونا الأميركية، عبر الهاتف صوتاً يقول "ساعديني يا أمي، أرجوكِ ساعديني".

وصدّقت الوالدة أنّ الصوت عائد لابنتها البالغة 15 عاماً والتي خرجت لممارسة التزلج.

تقول لمحطة تلفزيونية محلية، في حديث يعود إلى أبريل الماضي "كان الصوت مطابقاً لصوت ابنتي مع طريقة بكائها نفسها"، مضيفةً "لم أشك للحظة في أنها قد لا تكون هي".

وطلب المحتال الذي اتّصل بالوالدة من رقم مجهول، الحصول على مليون دولار أميركي لقاء إطلاق سراح الفتاة.

في الوقت الحالي، تخضع هذه الحادثة التي وصلت إلى نهايتها سريعاً بعدما تمكّنت ديستيفانو من التواصل مع ابنتها، إلى تحقيق من السلطات المختصة، وكان لها دور في تسليط الضوء على عمليات الاحتيال المحتملة بفعل استخدام مجرمي الإنترنت برامج الذكاء الاصطناعي.

"عمليات تزييف عميق مقنعة"

يؤكّد المدير التنفيذي لشركة "بلاكبيرد. ايه آي" وسيم خالد، في حديث صحفي، أنّ "النسخ الصوتي عبر الذكاء الاصطناعي والذي بات من شبه المستحيل تمييزه عن الصوت البشري، يتيح للأشخاص أصحاب النيات السيئة النية كالمحتالين الحصول على معلومات ومبالغ من الضحايا بأسلوب أكثر فعالية ممّا يعتمدونه في العادة".

وتتيح تطبيقات كثيرة مجانية ومُتاحة عبر الإنترنت بدرجة كبيرة، استنساخ الصوت الفعلي لشخص ما عبر برنامج للذكاء الاصطناعي يستند إلى تسجيل قصير لصوت هذا الشخص. ويمكن للمحتال أن يحصل على تسجيلات مماثلة من محتويات منشورة من الضحية عبر الإنترنت.

يقول خالد "من خلال تسجيل صوتي قصير، يمكن استخدام استنساخ صوتي أُنشئ استناداً إلى الذكاء الاصطناعي، لترك رسائل ومقاطع صوتية يُزعم أنها للضحية. وقد يُستخدم الصوت المُستنسخ أيضاً كصوت مُعدَّل أثناء المكالمات الحية".

عمليات احتيال متزايدة

في الصين، استخدم محتال تقنية الذكاء الاصطناعي لتغيير شكله وانتحال شخصية صديق له رجل أعمال لينتزع أكثر من نصف مليون يورو، على ما أفادت السلطات.

يوضح الضحية غوو أنه تلقى في أبريل الماضي، مكالمة عبر الفيديو من شخص بدا شبيهاً شكلاً وصوتاً بأحد أقاربه.

لكنّ الشخص، الذي كان يتحدث معه كان في الواقع محتالاً "استخدم تقنية الذكاء الاصطناعي لتعديل ملامح وجهه"، على ما ذكر مقال نشرته وسائل إعلام صينية في مايو الماضي.

وادّعى المحتال أن صديقاً آخر بحاجة ماسة إلى مبلغ من المال.

ونجح في إقناع غوو بتحويل 4,3 مليون يوان (نحو 614,89 ألف دولار أميركي) من الحساب المصرفي لشركته.

ونقل المقال عن رجل الأعمال قوله "أثناء المكالمة عبر الفيديو، كنت متأكداً من أنني عرفت وجه الشخص الذي يتصل بي وصوته. لذلك، كنت مطمئناً".

بعدما حوّل غوو المبلغ، بعث برسالة إلى صديقه الذي انتُحلت هويته.

وأدرك رجل الأعمال الخطأ، الذي اقترفه، عقب ردة الفعل التي أظهرها صديقه، فاتصل بالشرطة التي أمرت المصرف بوقف عملية التحويل.

واقتنع جدٌّ تعرّض لعملية احتيال بما سمعه لدرجة أنّه بدأ يجمع الأموال وفكّر في رهن منزله، قبل أن يتبيّن أنّ ما يحصل ليس سوى احتيال.

وفي حديث صحفي، يقول هاني فريد الأستاذ في كلية المعلومات بجامعة كاليفورنيا في بيركلي إنّ السهولة التي يتّسم بها استنساخ الصوت تعني أن "كل مستخدم للإنترنت معرض للخطر".

ويشير إلى أنّ "عمليات الاحتيال هذه آخذة في الازدياد".

صعوبة الوثوق بمحتوى الإنترنت

وتعيّن على شركة "إيليفن لابس" الناشئة الاعتراف بأنّ أداتها الناسخة للصوت من خلال الذكاء الاصطناعي يمكن استخدامها لأهداف مسيئة، بعدما نشر عدد من مستخدمي الانترنت مقطعاً مزيفاً للممثلة إيما واتسون وهي تقرأ مقاطع من كتاب.

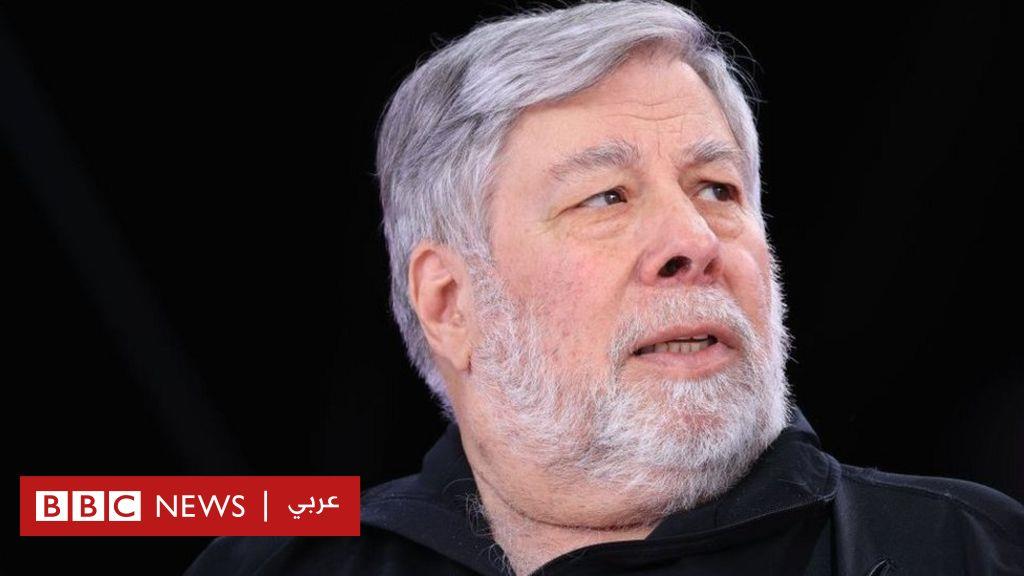

ويقول غال تال-هوشبيرغ، وهو مسؤول في شركة "تيم 8" المتخصصة في الاستثمارات التكنولوجية، "نقترب بسرعة من المرحلة التي لن يعود بإمكاننا فيها الوثوق بالمحتوى المنشور عبر الإنترنت، والتي سيتعين علينا خلالها الاستعانة بتقنيات جديدة لنتأكّد من أنّ الشخص الذي نعتقد أننا نتحدث معه (عبر الهاتف) هو بالفعل مَن نتواصل معه".